超高效AI模型,在CPU上运行

微软研究人员刚刚创建了 BitNet b1.58 2B4T,这是一个开源的 1 位大型语言模型 (LLM),拥有 20 亿个参数,基于 4 万亿个词元进行训练。该 AI 模型的独特之处在于其轻量级设计,能够在 CPU 上高效运行,TechCrunch 称 Apple M2 芯片也能运行该模型。该模型也可在 Hugging Face 上轻松获取,任何人都可以进行实验。

Bitnets 使用 1 位权重,且只有三个可能值:-1、0 和 +1——由于支持三个值,从技术上讲,它是一个「1.58 位模型」。与采用 32 位或 16 位浮点格式的主流 AI 模型相比,这节省了大量内存,使其能够更高效地运行,并减少对内存和计算能力的需求。然而,Bitnet 的简洁性也有一个缺点——与大型 AI 模型相比,它的准确性较低。不过,BitNet b1.58 2B4T 凭借其海量训练数据(估计超过 3300 万册书籍)弥补了这一缺陷。

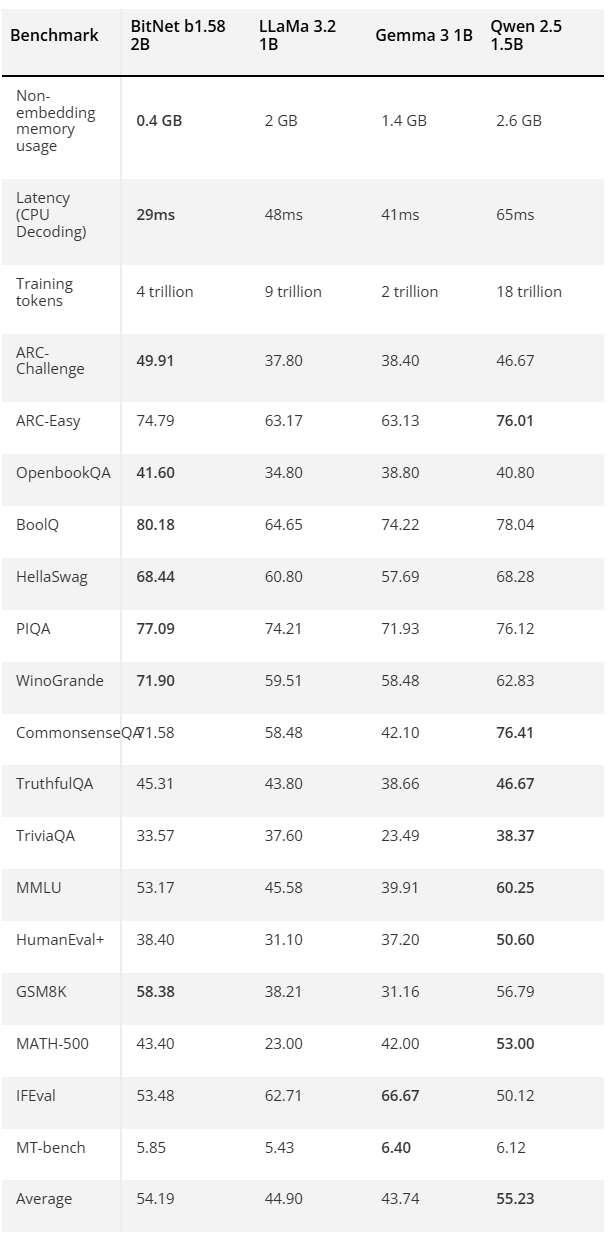

这款轻量级模型背后的团队将其与领先的主流模型进行了比较,包括 Meta 的 LLaMa 3.2 1B、谷歌的 Gemma 3 1B 和阿里巴巴的 Qwen 2.5 1.5B。BitNet b1.58 2B4T 在大多数测试中都比这些模型取得了相对不错的成绩,甚至在一些基准测试中获得了最高荣誉。更重要的是,它仅消耗了 400MB 的非嵌入式内存,不到第二小模型(Gemma 3 1B)1.4 GB 内存的 30%。

然而,LLM 必须使用 bitnet.cpp 推理框架才能高效运行。该团队特别指出,「即使使用必要的 fork,该模型与标准 Transformer 库一起使用时,也不会获得性能效率提升」。

如果您想在轻量级硬件上充分利用其优势,则需要获取 GitHub 上提供的框架。该存储库将 bitnet.cpp 描述为「提供一套优化的内核,支持在 CPU 上快速无损地推理 1.58 位模型(后续将支持 NPU 和 GPU)。虽然它目前不支持 AI 专用硬件,但它仍然允许任何拥有计算机的人在无需昂贵组件的情况下进行 AI 实验。

人工智能模型常常因训练和运行耗能过高而受到诟病。但轻量级的 LLM(例如 BitNet b1.58 2B4T)可以帮助我们在性能较弱的硬件上本地运行人工智能模型。这可以减少我们对大型数据中心的依赖,甚至让那些无法使用内置 NPU 的最新处理器和最强大 GPU 的人也能使用人工智能。

可以看到,微软正在 AI 领域做更多的探索。前不久,微软正将旗下多项人工智能功能全面开放给搭载英特尔和 AMD 芯片的 Copilot Plus PC。此前,这些先进的 AI 特性主要面向配备高通芯片的同类电脑。此次功能更新中最引人注目的是「实时字幕」(Live Captions)。这项功能能够实时将数十种不同语言的音频翻译成英文字幕。微软早在去年 12 月就开始在搭载英特尔和 AMD 芯片的设备上测试该功能,而现在,通过最新的 Windows 11 更新,所有符合条件的 Copilot Plus PC 用户都可以使用这个强大的工具。

除了实时字幕外,本次更新还包括了画图应用(Paint)中的 AI 工具「协同创作者」(Cocreator)。用户只需输入文字描述,并结合当前的绘画内容,协同创作者便能生成相应的图像。此外,微软还将进一步扩大照片应用中 AI 图像编辑器和生成器的使用权限,让更多用户能够轻松进行智能图像处理和创作。

值得注意的是,此前这些 AI 功能仅在采用高通芯片的 Copilot Plus PC 上提供。微软去年已开始在英特尔和 AMD 设备上测试另一项名为「Recall」的 AI 功能。该功能可以截取用户在 Copilot Plus PC 上的活动屏幕截图,并允许用户进行搜索。尽管如此,微软尚未公布 Recall 功能何时能够正式向所有用户开放。

与此同时,微软还在搭载高通芯片的 Copilot Plus PC 上更新了「语音访问」(Voice Access)功能。这是一项辅助功能,旨在帮助用户通过语音控制电脑。微软表示,使用高通芯片设备的语音访问用户现在将能够「使用更具描述性和灵活性的语言与他们的电脑进行交流」。此外,本次更新还新增了将 27 种语言翻译成简体中文的功能。微软方面透露,计划在未来将这两项语音访问的更新推广到搭载英特尔和 AMD 芯片的设备上。

上一篇:国产模拟芯片,蛰伏出击