抖音背后的算法推荐逻辑

推荐算法已并非新生事物,但围绕它的争议却从未间断。这些争议包括推荐算法带来标题党、低质量、甚至虚假内容以及信息茧房的问题。很多人对推荐算法技术存在误解,认为算法是给内容打上对应标签,再给用户打上对应的属性,最后通过数据运算,把对应标签的内容推荐给有对应属性的用户。实际上,随着机器学习技术的发展,抖音的推荐系统已几乎不依赖对内容或者用户打标签,而是通过复杂的神经网络计算,直接预测每个用户对每条内容可能产生的互动行为概率。

机器学习对推荐算法的主要贡献在于建立评分系统,在海量算力和海量供给的环境里,把用户行为抽象成数学里的映射关系,给用户推荐以他为标准的高评分内容的目标。

算法会围绕用户的反馈建模,有没有点赞、看到了第几秒、写了什么评论、是否点开了作者主页……等等,这些互动都会让算法对一个用户的了解逐渐加深,是抖音推荐算法的「北极星指标」,最终越来越准确的“预测”用户行为的发生率,就是把反馈价值最高的视频推给用户。这意味着,在这个高密度的数据化时代,算法无需深入理解内容的具体类型或语义,就能高效预测用户的潜在兴趣和行为。

抖音背后的算法

过去短视频平台的推荐算法是在给内容和用户打标签,然后去做相互匹配,甚至产生了很多教人在养号时怎么引导系统给自己打标签的玄学。然而,标签机制是人工编辑时代的经验残余,是让算法模仿人类的糊涂做法,只有在非常早期的推荐算法里才有用过,当机器学习的技术成熟之后,依靠几百个标签去理解内容的做法就完全被淘汰掉了。

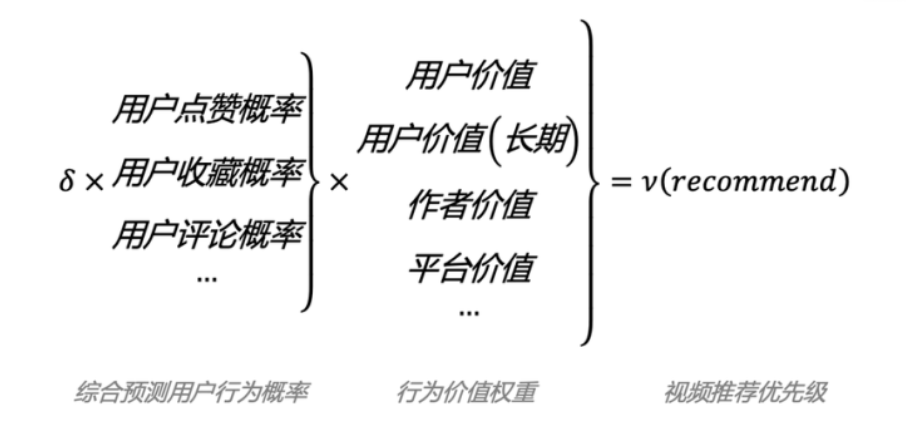

近日,抖音安全与信任中心网站已上线试运营,公开了抖音算法推荐系统的原理、用户行为背后的算法推荐逻辑以及平台人工治理识别各类风险等内容。当前抖音推荐算法的核心逻辑可以简化为“推荐优先级公式”:综合预测用户行为概率×行为价值权重=视频推荐优先级。

推荐优先级公式

抖音推荐算法作为人工智能机器学习技术的重要应用场景,本质上是一套高效的信息过滤系统。在抖音的实际应用中,所有在平台发布的内容都会经过评估,流量越高的内容经过评估的次数越多,标准也越严格,“人工+机器”审核相互分工又密切配合 —— 机器负责「宽度」评估所有投稿,人工负责「深度」。创作者将内容上传至后,首先进入机器识别环节:如果内容被识别出含有高危特征,将被直接拦截;若未命中高危特征但模型判断有问题,则会送至人工审核,若问题概率较低,则获得基础流量进入下一环节。内容被举报、评论区出现集中质疑、流量激增等情况出现,均可能触发再次审核,并导致停止进一步推荐和分发的处置。

抖音基于用户行为的推荐方法包含多种技术模型,如协同过滤、双塔召回、Wide&Deep模型(均为推荐系统中常用模型)等。算法可以在完全“不理解内容”的情况下,找到兴趣相似的用户,把其他人感兴趣的内容推荐给该用户。

· 协同过滤推荐算法是最经典的推荐算法,基于内容的协同过滤算法会分析和比较用户行为。比如,用户A观看了内容X、Y、Z,用户B观看了内容X、Z、W,用户C观看了内容X、Z、V,算法就会判定X和Z之间就有较高的相似度,系统会根据用户对已观看或已评分内容的偏好,为用户推荐与这些内容相似的其他内容。其原理就是,找到和你兴趣相似的用户,把他们感兴趣的内容也推荐给你。

· Wide&Deep模型是抖音推荐算法主力模型之一,由Wide部分和Deep部分组成。Wide部分的主要作用是让模型具有较强的“记忆能力”,模型可直接学习并利用历史数据中物品或者特征的“共现频率”;Deep部分的主要作用是让模型具有“泛化能力”,能够发掘稀疏甚至从未出现过的稀有特征与最终标签相关性。以知识图谱的跨域推荐,助力信息高效分发和连接,能够解决协同过滤算法推荐结果头部效应比较明显的问题。

当Wide&Deep模型与协同过滤算法共同发挥作用,平台既可以快速推荐热门内容,又能挖掘用户潜在的多样化兴趣,让小众内容能被更多用户关注。从推荐算法来看,抖音与国内外大部分内容推荐平台相似,包含召回、过滤、排序等环节,而从数以亿计逐渐减少到数以万计、数以千计,直到筛选出几条用户能够刷到的内容,一切都要依靠算法的「召回」能力。

如何简单地理解「召回」:假设问一个知道结果的球迷“哪支球队是冠军”,那么需要猜多少次才能知道世界杯冠军?「召回」方式是把32支球队编号,从1到32,然后提问“冠军在1号到16号之中吗”?如果猜对了,就继续问“冠军在1号到8号之中吗”?如果猜错了,那么就知道冠军必然在9号到16号之间。这就是数学模型的本事,它并不需要知道这32支球队的强弱关系,却能以低且简洁的成本最大概率「召回」答案。

基于机器学习和深度学习构建的推荐算法,提升了超大规模信息分发、推荐的效率,能交付人类难以快速高效完成的任务。从行为发生到现实有效反馈的时间已经非常短,这种近似即时调整的机制,有助于算法更精准地预判用户行为。抖音已经实现了“分钟级”实时反馈更新。

但由于算法是通过数据收集、特征工程、模型训练等复杂流程尝试复刻用户选择的不确定性,其本质是数学模型的运算过程,而非理解内容本身,因此依然有其局限性。也正是因为这个特性,抖音曾尝试直接给知识、历史、科技等深度内容做加热,但实际效果不佳。此举改变了算法的正常逻辑,会影响数据循环,导致这些内容的后续推荐受到干扰;此后,抖音转换思路,针对深度内容训练,预估收藏和重复观看概率的模型,使平台中的深度内容分发效率更高。

价值模型就是对用户的互动行为进行价值计算,并通过不断调整参数,对各类价值进行加权,代表了抖音对于哪些动作可能更重要的理解。简单来说,如果仅考虑用户交互概率,可能会造成一些问题,比如,一些精心制作的中长优质视频可能因为完播率较低,而在分发中处于劣势地位。通过对这些因素的深入分析和权衡,「价值最大化」原则能够为每个候选内容计算出反映其潜在价值的分数,从而为后续的推荐提供有力的依据。

而正是由于算法推送内容的规律性,近年来在实践层面,用户对于“反向驯化”算法乐此不疲 —— 不连续点赞同类视频、不使用平台搜索记录、不定期清除浏览痕迹,通过这种刻意制造“数据噪声”更积极地驯化、制衡算法,主动告诉算法自己的需求和偏好,倒逼平台算法提升推荐服务水平。

算法大时代

推荐算法的本质是信息过滤系统,这和信息爆炸的环境有关。根据IDC的报告显示,全球产生的数据量2024年达159ZB,到2028年将达384ZB。需要说明的是,1ZB等于10万亿亿个Byte,如果以一部约两小时的4K电影约20G的大小来衡量,159ZB相当于7.95万亿部电影,连续播放这些电影需要约18亿年。这已完全超出了历史上任何一个时代需要处理的信息体量。

抖音每天新增视频高达亿数量级,而普通用户平均每天能够消费的视频撑死了也就几百条,那么在这有限的几百条视频里,怎么尽可能的确保它们都是用户喜欢的,就是算法需要不断精进的母题。不少人将算法视作信息茧房推手,但事实与之相去甚远。

信息茧房一词来源于美国法学教授凯斯·R·桑斯坦2006年出版的《信息乌托邦》,指如果人只关注和选择自我愉悦的内容,信息接触面便会越来越窄,困于自我编织的茧房中。事实上,这一概念提出时并非针对算法,也没有实证研究和量化数据支撑。

社交媒体、搜索引擎等不同网络平台实际上扩充了用户的信息源,不同观点的网络用户集群之间不会完全隔离,使用户接触到的信息多样性高于不使用这些平台的用户。但即使是最优秀的算法工程师,也无法脱离算法技术的种种理论和架构,简单解释为什么把某个视频推荐给了这些用户而非那些用户 —— 当每个用户都变成数据里的“点”时,用户无法纵览全貌,必然极易感觉身处黑盒当中。

此外,算法治理已成为当今平台面临的共同问题。中央网信办以压实网站平台主体责任为抓手,出台系列政策法规,构建算法备案、安全评估、监测检查、执法处罚等全流程监管体系,加强算法治理。只有提高算法设计的透明度和算法运行的可解释性,才能守好算法应用“责任田”。